Mo Fang

Schätzung der Posen bewegter Kameras mit Hilfe von Landmarken

Dauer der Arbeit: 6 Monate

Abgabe: Februar 2015

Betreuer: M.S. Dipl.-Math. Jens Kühnle (Fraunhofer/IPA)

Betreuer & Prüfer: Prof. Dr.-Ing. Norbert Haala

Einleitung

Industrieroboter gehören heute zu den wichtigsten Werkzeugen in der Produktion. Dennoch genügen Roboter häufig nicht den Genauigkeitsanforderungen, insbesondere bei der optischen Messtechnik. Zur Steigerung der Robotergenauigkeit kommen dann „externe Messsysteme“ zum Einsatz, die es ermöglichen die Position und Orientierung des Endeffektors während der Bewegung zu messen und zu korrigieren. In dieser Arbeit wird ein photogrammetrisches Messsystem zur Steigerung der Genauigkeit von Industrierobotern untersucht. Im Unterschied zu vielen kommerziellen photogrammetrischen Messsystemen werden dabei mehrere Kameras am Roboterendeffektor befestigt und die Kamerabewegung aus der Bildsequenz geschätzt (s. Abb. 1). Statt (codierten) Zielmarken werden dazu Landmarken aus der Umgebung verfolgt.

Implementierung

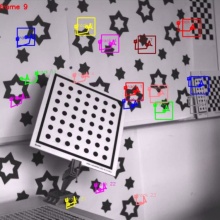

Es wurden zwei getrennte Programme in dieser Arbeit implementiert. Im ersten Programm werden Ecken mit dem Shi-Tomasi Eckendetektor aus einzelnen Bildern extrahiert (s. Abb. 2, links). Die korrespondierenden Ecken in der Bildsequenz wurden durch Auswertung des optischen Flusses mit dem Lucas-Kanade Eckentracker ermittelt und verfolgt (s. Abb. 2, rechts).

Im zweiten Programm wurden die 6D-Kameraposen (d.h. Position und Orientierung) und die 3D-Koordinaten der getrackten Strukturpunkte schrittweise mit Structure-from-Motion Verfahren und Bündelausgleichung geschätzt. Da bei Structure-from-Motion Verfahren die Kameraposen und Strukturpunkte in ein willkürliches Modellkoordinatensystem und in falschem Maßstab sind, müssen die berechneten Kameraposen in das Koordinatensystem der Referenzdaten transformiert werden. Dazu wurden in dieser Arbeit zwei Ansätze untersucht, die Ausrichtung mit Passpunkten und die Ausrichtung mit initialen Kameraposen. Zudem wurden Structure-from-Motion und Bündelausgleichung mit mehreren Kameras implementiert. In Abbildung 3 sind die geschätzten Kamerabewegungen der Kameras (rot) und die rekonstruierten 3D-Strukturpunkte (blau) visualisiert.

Da im Rahmen dieser Arbeit zur Überprüfung der Ergebnisse kein externes Messsystem zur Verfügung stand, wurden Referenzdaten mit extrinsischer Kamerakalibrierung erstellt. Dazu war es bei den Experimenten wichtig, eine Kalibrierplatte in der Szene zu platzieren. In mehreren Experimenten und Tests wurde festgestellt, dass unsere Implementierung und die Ausrichtung funktionieren. Es wurden Bildsequenzen mit einer und zwei Kameras aufgenommen und die berechneten Kamerabewegungen mit den Referenzdaten verglichen. Bei der Ausrichtung mit Passpunkten wurden die absoluten Abweichungen betrachtet. Der translatorische Fehler beträgt ca. 0,5 mm und der rotatorische Fehler beträgt ca. 1,0 mrad. Bei der Ausrichtung mit initialen Kameraposen wurden die relativen Abweichungen betrachtet. Zusätzlich wurden die initialen Kameraposen verfälscht. Es wurde festgestellt, dass sogar mit fehlerbehafteten Kameraposen der Maßstab korrekt gefunden wurde. Der translatorische Fehler beträgt ca. 0,4 mm und der rotatorische Fehler beträgt ca. 0,6 mrad. Diese Ergebnisse setzen jedoch eine Normalverteilung der Fehler voraus.

Fazit

Die Qualität der Tracks hat großen Einfluss auf die Ergebnisse. Bei Experimenten wurde festgestellt, dass bei natürlichen Landmarken die Pixelfehler der Korrespondenzen sehr groß werden können. Deshalb wurde bei Experimenten mit künstlichen Landmarken gearbeitet, die mit den implementierten Algorithmen verfolgt wurden.

Zusammenfassend können die Kameraposen durch Ausrichtung mit Passpunkten etwas genauer als durch Ausrichtung mit Kameraposen geschätzt werden. Außerdem ist die gleichzeitige Schätzung der gemeinsamen Kamerabewegungen genauer als die separate Schätzung der einzelnen Kamerabewegungen. Die translatorischen und rotatorischen Abweichungen sind sowohl für die einzelnen Kameras als auch für beide Kameras kleiner.

Ansprechpartner

Norbert Haala

apl. Prof. Dr.-Ing.Stellvertretender Institutsleiter