Kailun Huang

Deep-Learning based Building Detection in Rasterized 3D Airborne Laser Scanning Data

Dauer der Arbeit: 4 Monate

Fertigstellung: August 2023

Betreuer: Dr.-Ing. Dominik Laupheimer

Prüfer: Prof. Dr.-Ing. Norbert Haala

Einführung

In den letzten Jahrzehnten hat die Welt eine rasche Verstädterung erlebt, wobei bereits heute mehr Menschen in Städten als in ländlichen Gebieten leben und die Stadtbevölkerung bis 2050 voraussichtlich auf 68,4% der Gesamtbevölkerung anwachsen wird. Die rasche Urbanisierung hat eine Reihe von Problemen mit sich gebracht, wie z.B. den hohen Energieverbrauch von Gebäuden und die Herausforderungen bei der Verwaltung der Nutzung städtischer Ressourcen. Um solche Probleme abzumildern und die Lebensqualität der Bewohner zu verbessern, das Konzept der Smart-City wurde entwickelt, während die LiDAR-Technologie eine weit verbreitete Vermessungsmethode zur schnellen Erfassung von 3D-Geländedaten ist und sich in den letzten Jahren bereits zu einem wichtigen Bestandteil vom Smart-City entwickelt hat, wobei eine der Hauptaufgaben darin besteht, aus den gewonnenen Punktwolken sinnvolle Objekte bzw. Strukturen zu erkennen. Mittlerweile ist die Objekterkennung auf Bilder mittels Deep Learning, insbesondere mittels Convolutional Neural Network, weit verbreitet und weist eine zufriedenstellende Performance auf. Es besteht daher Forschungsbedarf, die Objekterkennung mittels Deep Learning auch auf Punktwolkendaten zu untersuchen.

Methodik

Das Untersuchungsgebiet in dieser Bachelorarbeit ist Huangshan, eine typische Stadt in China, die sich seit kurzem in der Entwicklung befindet. Eine ALS-Punktwolke wird zunächst mit den spektralen Attributen des RGB-Orthophotos und des Satellitenbildes aus dem Sentinel-2 Level 2-A Produkt versehen und anschließend zu einem Merkmalsbild mit 8 Kanälen gerastert. Die manuell definierten Bounding Boxes werden als Ground Truth verwendet und zusammen mit dem Merkmalsbild in einem Datensatz gebildet. Das vortrainierte Faster R-CNN Modell aus dem PyTorch Package wird in dieser Bachelorarbeit verwendet. Aufgrund der begrenzten Leistungsfähigkeit der verwendeten GPU ist der Datensatz in Kacheln mit einem Überlappungsbereich aufzuteilen. Die Prädiktionen in den Kacheln müssen schließlich wieder in das ursprüngliche Merkmalsbild zurücktransformiert werden, wofür verschiedene Methoden zur Behandlung von doppelten Prädiktionen nach der Transformation getestet und verglichen werden.

Ergebnisse

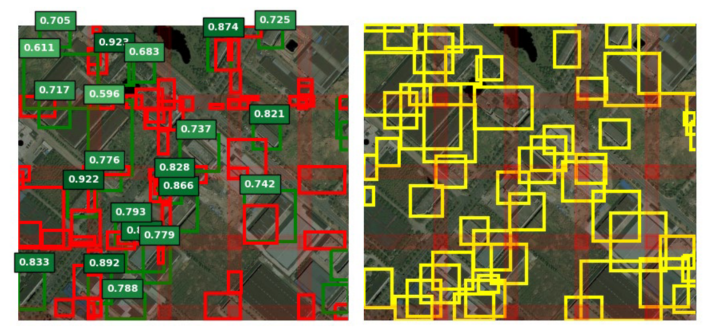

Von den vier getesteten Methoden schneidet Soft-NMS am besten ab. In Abbildung 1 sind die Prädiktionen in einem kleinen Ausschnitt des Testgebietes mit dem vordefinierten Ground Truth verglichen, wobei die TP-Prädiktionen grün, die FP-Prädiktionen rot und GT gelb dargestellt sind. Zusätzlich sind für die TP-Prädiktionen die entsprechenden Confidence Scores in farbcodiert gekennzeichnet.

Links: Prädiktionen (TPs in Grün, zusätzlich mit farbcodierten Confidence Scores, FPs in Rot dargestellt); Rechts: Ground Truth (in Gelb dargestellt)

Ausgewählte Literatur

[1]. Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. Advances in neural information processing systems, 2015, 28.

[2]. Lin T Y, Maire M, Belongie S, et al. Microsoft coco: Common objects in context[C]. Computer Vision–ECCV 2014: 13th European Conference, Zurich, Switzerland, September 6-12, 2014, Proceedings, Part V 13. Springer International Publishing, 2014: 740-755.

[3]. Bodla N, Singh B, Chellappa R, et al. Soft-NMS--improving object detection with one line of code[C]. Proceedings of the IEEE international conference on computer vision, 2017: 5561-5569.

Ansprechpartner

Norbert Haala

apl. Prof. Dr.-Ing.Stellvertretender Institutsleiter